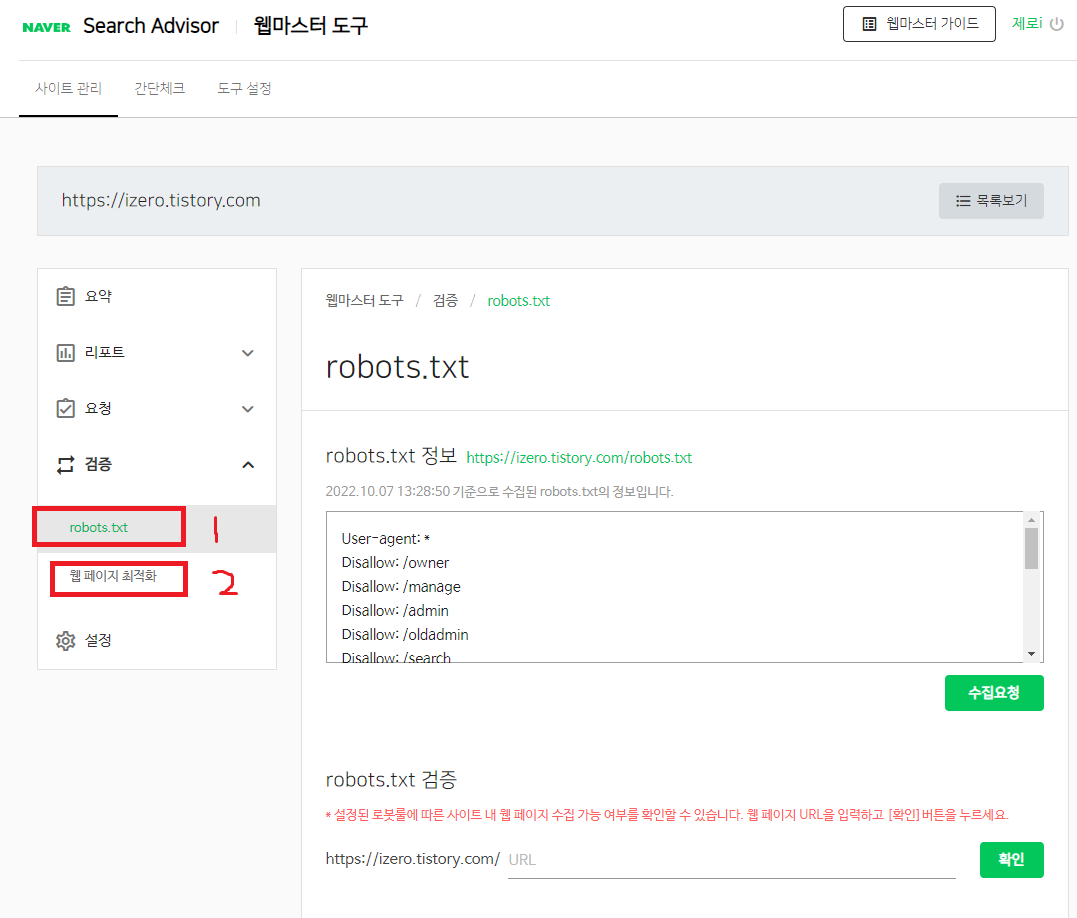

마지막을 장식할 robots.txt와 웹 페이지 최적화.

이제 드디어 네이버 서치 어드바이저의 마지막 편이다.

검증에는 robots.txt 와 웹페이지 최적화가 있다.

robots.txt << 이친구는 전에도 말했지만 각 포털 사이트 (네이버 구글 다음 등등등) 사이트맵과 웹페이지를 자신들의 포털 사이트로 가지고 가게 만들어 준다.

각 포털 사이트 마다 로봇의 이름이 있다.

각 포털 사이트의 로봇들의 이름.

네이버 -> Yeti

구글 -> Googlebot

다음 -> Daumoa

MS -> Bingbot

각자 다른 로봇들이 존재한다. 이 녀석들을 robots.txt 파일에 허용해야지 검색을 하는데...

문제는 아예 robots.txt 파일이 없어도 검색을 하긴 한다. 가지고 가지 말라고 한 것까지 가지고 가는 게 문제지...

곰 세끼 같은 경우는 네이버,구글,MS,JUM 4개를 등록했다. 다음은 티스토리니까 당연하게 등록이 되니까 PASS~

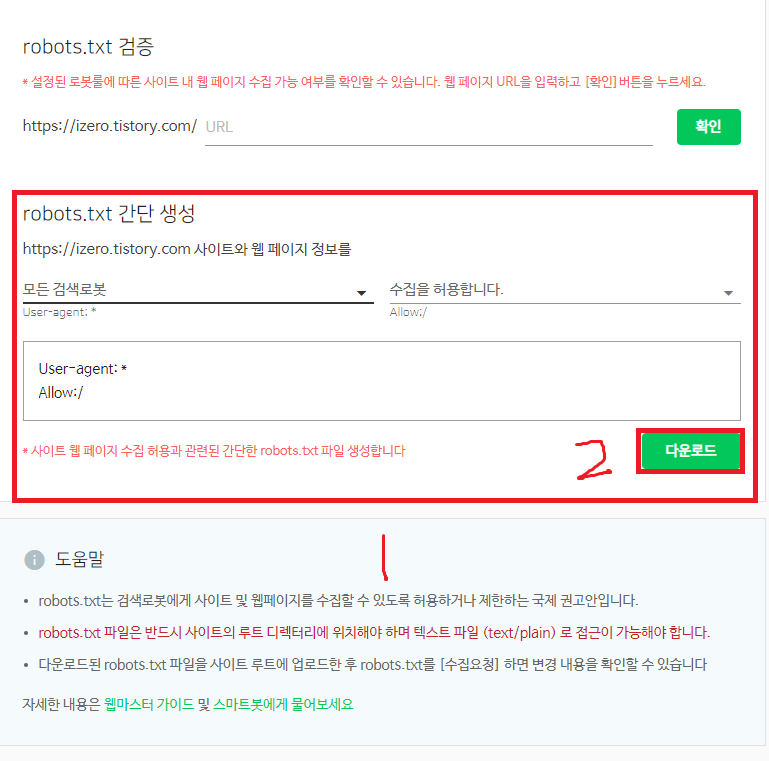

모든 검색 로봇으로 바꾸고 다운로드를 받는다.

그러면 robots.txt 파일이 다운로드가 될 것이다.

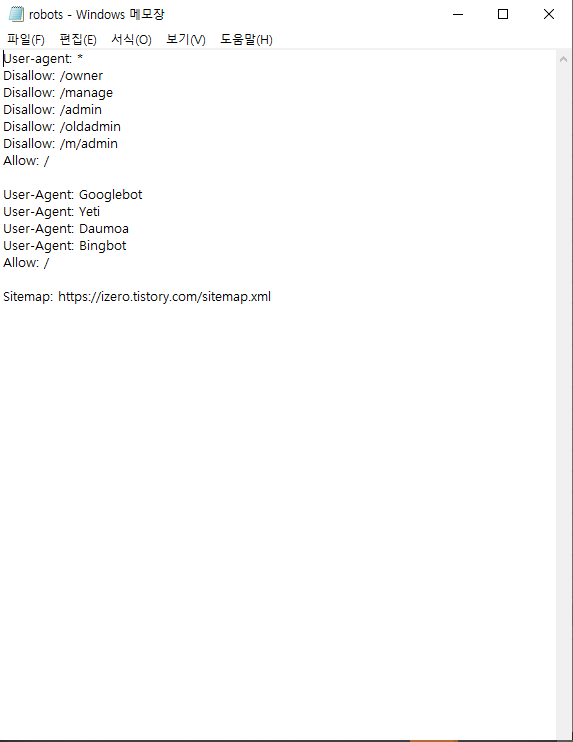

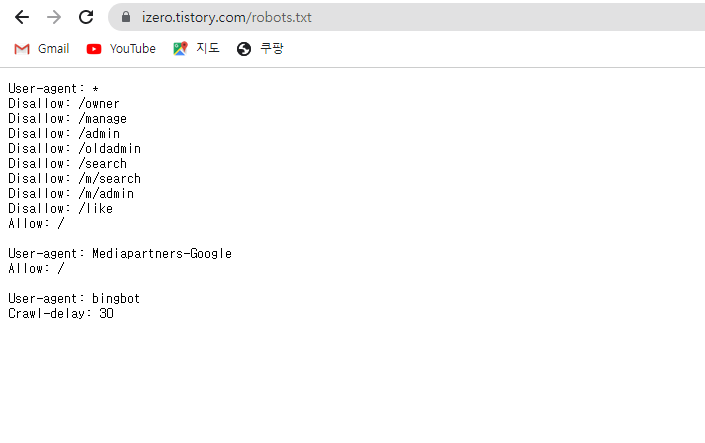

곰 세끼가 설정한 robots.txt를 보여주면서 설명하도록 하겠다.

간단한 승인과 거부의 명령어.

Disallow < 거부

Allow < 승인

이렇게 보면 간단하다.

거부 이것들은 매니저, 오너, admin(관리자)라고 보면 된다 전부 중요한 것이니까 거부하는 것이 좋다. 그리고 나머지는 승인한다고 보면 된다.

그다음 승인은 각 포털의 로봇들을 승인한다는 것이다.

이렇게 하면 robots.txt의 작성이 끝이 난다. 이제 이 파일을 루트 디렉터리로 가져가야 하는데...

루트 디렉터리를 모르시는 분들은 한참 헤맬 것이라고 생각한다.

하지만 티스토리에 할 수 있으니까 걱정하지 말도록 하자.

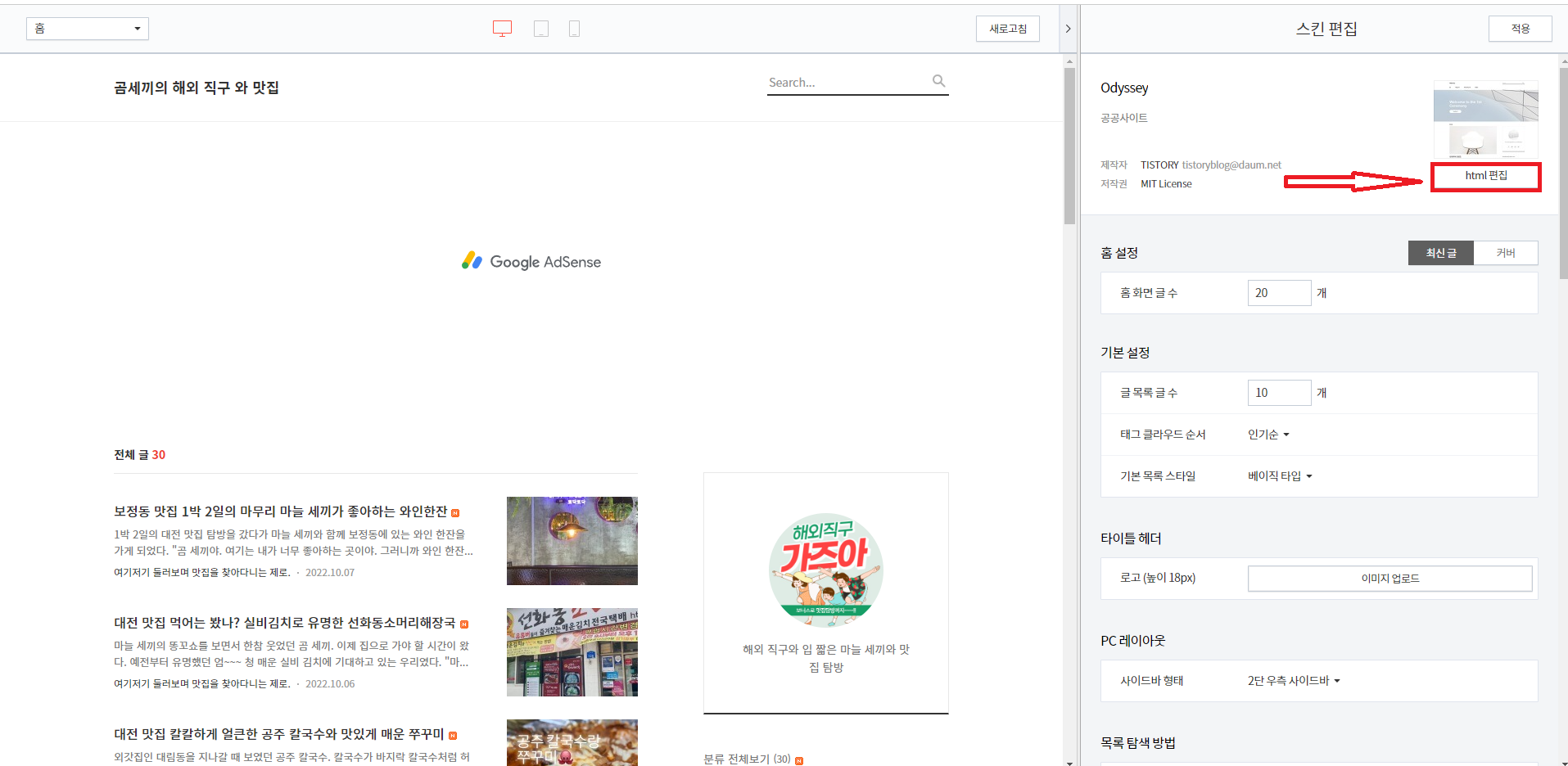

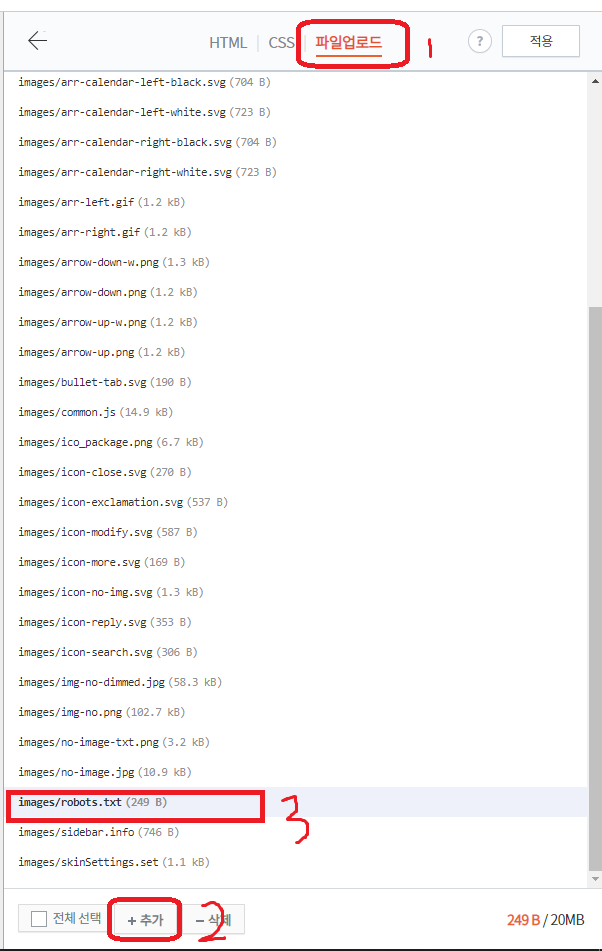

스킨 편집으로 이동해서 html 편집으로 들어가도록 하자.

파일 업로드를 누르고 +추가를 눌러서 robots.txt 파일을 추가하도록 하자.

이렇게 하면 robots.txt 파일을 루트 디렉터리에 넣는 것이 끝이 난다.

하지만!!!

중요한 것이 있다. 이렇게 robots.txt를 넣어도 티스토리에서는 robots.txt가 고정되어있기 때문에 적용이 되지 않는다...

본인의 티스토리에 robots를 확인하려면 위와 같이 적어 주면 된다.

본인의 도메인/robots.txt

그러면 본인 사이트에 저장되어 있는 robots.txt 파일의 명령어들을 볼 수 있다.

티스토리는 고정되어 있으니 바뀌지 않는다고 보면 된다.

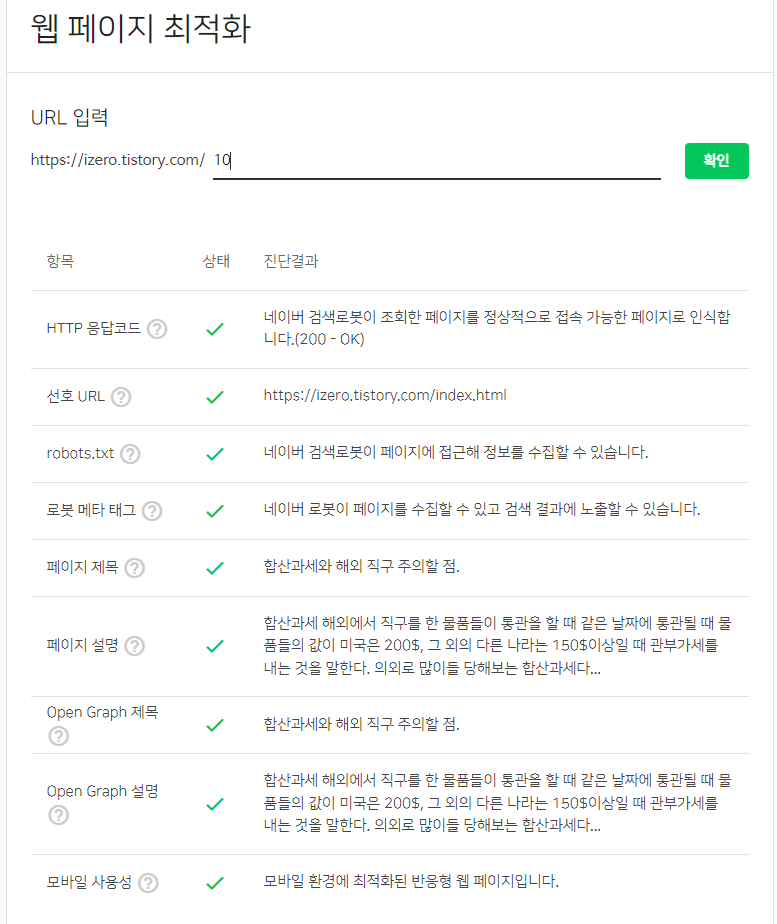

이제 웹페이지로 넘어가 보자.

웹페이지는 별거 없다. 최적화가 잘되어 있는지 글마다 확인할 수가 있다는 점.

검사 결과 잘 나와 있다면 걱정하지 않아도 된다.

이렇게 네이버 서치 어드바이저를 마무리해본다. 다들 잘 이해하고 사용했으면 좋겠다.

'티스토리 > 블로그의 시작' 카테고리의 다른 글

| [SNS로 티스토리에 오게 하자] 트위터, 페이스북, 카카오 스토리 (35) | 2022.10.11 |

|---|---|

| [구글 서치 콘솔 초보자를 위한 설정하기(1)] (8) | 2022.10.11 |

| [네이버 서치어드바이저 초보자를 위한 설정하기(3)] 요청 (0) | 2022.10.03 |

| [네이버 서치어드바이저 초보자를 위한 설정하기(2)] 리포트 (0) | 2022.10.02 |

| [네이버 서치어드바이저 초보자를 위한 등록하기(1)] (2) | 2022.10.01 |

댓글